Hi AInauten,

Willkommen zur neuen Ausgabe deines Lieblingsnewsletters.

Heute vollgepackt mit Praxistipps rund um Sprachmodelle. Wie du sie kostenlos offline nutzt, und warum es wichtig ist, die Stärken und Schwächen der einzelnen AI-Sprachmodelle zu kennen. Besonders dann, wenn du mit ihnen arbeiten willst!

Hier die Themen:

🤖 Dein eigener AI-Supercomputer von NVIDIA

💻 AI-Sprachmodelle ohne Internet kostenlos nutzen

⚠️ Vorsicht bei der Datenanalyse mit AI

Los geht’s!

🤖 Dein eigener AI-Supercomputer von NVIDIA

Wir müssen zum Start natürlich über die Keynote von Jensen Huang, CEO von NVIDIA, auf der CES in Las Vegas sprechen.

Wie immer bei NVIDIA war das Ganze oft sehr technisch und auf jeden Fall über unserer Gehaltsstufe. Obwohl wir uns die ganze Zeit dachten, “Krass, das ist Zauberei!”, macht es extrem Spaß einem Genie wie ihm zuzuhören.

Für alle Nicht-Techies (wie uns) im Folgenden das Wichtigste zusammengefasst … und falls du alle Details willst, hier die ganze Keynote und hier der Supercut in 10 Minuten.

Dieses Bild zeigt wieder sehr gut, auf welcher Entwicklungsstufe wir uns in Sachen AI befinden. Während die meisten von uns noch mit der Generative AI beschäftigt sind, also Content Creation, Marketing und Chatbots, ist NVIDIA schon zwei Stufen weiter.

Die nächste Phase sind AI Agents, auf die wir dieses Jahr auch stark fokussieren werden. Und weil alle Voraussetzungen da sind ist bei NVIDIA jetzt sogar schon die Physical AI live. Sprich: Roboter, selbstfahrende Autos, automatisierte Fabriken, die die Welt um sich herum verstehen.

Es ist so cool zu sehen, was hier heute schon Wirklichkeit ist und wie schnell sich der Bereich entwickelt.

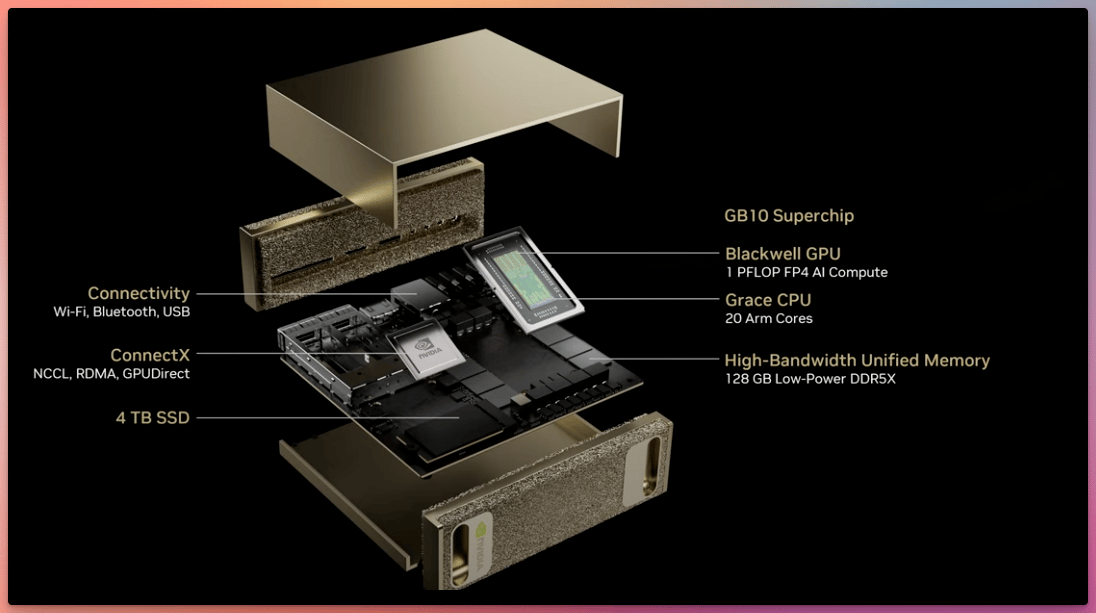

AI lokal nutzen mit einem eigenen Supercomputer

Das spannendste Thema für uns war aber das “Project Digits”. Das ist NVIDIAs AI-Supercomputer für Privatleute.

Wir ersparen dir die ganzen technischen Eigenschaften wie 1 Petaflop Compute Power und 128GB Memory… Und merken uns: das kleine Ding hat richtig Power!

Damit kannst du viele AI Sprachmodelle, Bildmodelle etc. ganz lokal bei dir ohne Cloud und Internet mit ordentlicher Geschwindigkeit laufen lassen.

Das Beste: Er soll im Mai 2025 auf den Markt kommen. Klar, das Ding ist mit voraussichtlich 3.000 Euro Startpreis kein Schnäppchen, aber für echte Nerds eine interessante Investition.

Und wer jetzt keine 3.000 Euro investieren will oder heute schon damit loslegen möchte, AI lokal auf dem eigenen Computer zu nutzen, liest bitte weiter. 😉

💻 AI-Sprachmodelle ohne Internet kostenlos nutzen

Wir erhalten immer wieder Fragen aus der Community, wie man am besten AI Modelle bei sich lokal auf dem Computer nutzt.

Also 100 % datenschutzkonform, ohne Internet usw.

Wir haben bereits vor über einem Jahr darüber geschrieben und Wege aufgezeigt. Bevor wir dir jetzt den aktuell einfachsten Weg beschreiben, wie du es nutzen kannst, gibt es eine wichtige Voraussetzung:

AI braucht gute Hardware!

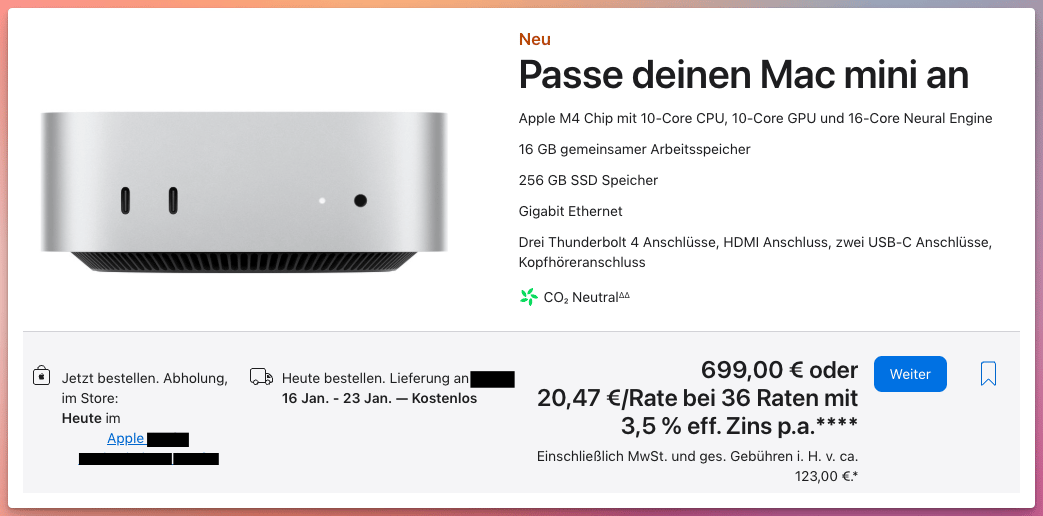

Ohne einen guten Computer wirst du nicht viel Spaß haben. Den unserer Meinung nach besten Deal, was Preis vs. AI-Power angeht, findest du ausgerechnet bei Apple:

Die günstigste Version des Mac Mini mit dem M4 Chip sollte für die meisten Ansprüche mehr als ausreichen. Das gibt dir unglaubliche Power für Sprach- oder auch Bildmodelle.

Und das zu einem sehr fairen Preis.

Kleine Sprachmodelle und auch Bildmodelle laufen aber auch auf deutlich älteren Computern. Daher probiere es ruhig einmal aus, bevor du investierst.

So kannst du schnell ein Sprachmodell lokal nutzen

Der einfachste, schnellste und auch kostenlose Weg aktuell ist über Ollama.

Du lädst einfach die kostenlose App herunter und installierst sie.

Dann öffnest du dein Terminal oder Console und gibst folgenden Befehl ein:

ollama run llama3.2Damit wird automatisch das Modell Llama 3.2 heruntergeladen, und du kannst direkt in der Console sofort lokal und kostenlos damit chatten.

Und das Modell nimmt mit knapp 2 Gigabyte auch nicht sehr viel Platz auf der Festplatte ein.

Auf der Ollama Webseite siehst du viele weitere Modelle, die du herunterladen und sofort nutzen kannst. Auch Mistral oder DeepSeek ist dabei, ideal für Programmierung, und es gibt viele, viele mehr.

So richtest du ein vernünftiges Chat Interface ein

Wer jetzt nicht so Bock hat, über die Console zu schreiben und stattdessen ein ChatGPT Style Tool sucht, der kann sich Chatbot Ollama oder Lobe Chat anschauen.

Beide sind Open Source und kostenlos. Wer technisch nicht so versiert ist, nutzt dafür am besten den Pinokio Browser. Damit sind die Tools in 2 Minuten installiert.

Für alle AInauten Premium Mitglieder: Wir werden in den nächsten Tagen auch noch ein Walkthrough Video zu dem ganzen Thema veröffentlichen, mit Details zu Pinokio, Ollama und Co. - kommt dann in einer separaten Mail.

Falls du noch nicht bei Premium mit dabei bist, hier entlang. See you on the other side!

⚠️ Vorsicht bei der Datenanalyse mit AI

Kommen wir wieder einmal zu einem kleinen Case aus der Praxis. Wir haben ja schon oft darüber geschrieben, dass man je nach Anwendungsfall unterschiedliche Chatbots und Sprachmodelle verwenden sollte.

Zum Beispiel ist Anthropic Claude 3.5 Sonnet unserer Meinung nach immer noch das beste Model, wenn du Werbe- und Marketingtexte brauchst.

Bei komplexen Fragestellungen nutzt du am besten OpenAIs o1.

Bei umfangreichen Daten und langen Unterhaltungen Google Gemini 2.0 Flash.

Für Mathe-Themen und Programmieren am besten das preislich günstige DeepSeek V3 oder Meta Llama 3.3.

Und falls du ein eher unzensiertes Model mit wenig Guardrails suchst, bietet sich Nous Hermes oder auch xAI Grok 2 an.

Wie wichtig die Modellauswahl ist, wird uns immer wieder bewusst, wenn wir verschiedene Arten von Daten analysieren.

Hier zum Beispiel ein Case aus der Praxis: Aus einer (vorher anonymisierten Leadliste) sollen Dubletten und mögliche Testleads gefiltert werden, um danach die Gesamtanzahl je Lead-Art und Zeitraum zu ermitteln.

Das richtige Ergebnis wäre im Beispiel unten 42.

So performen die unterschiedlichen Modelle

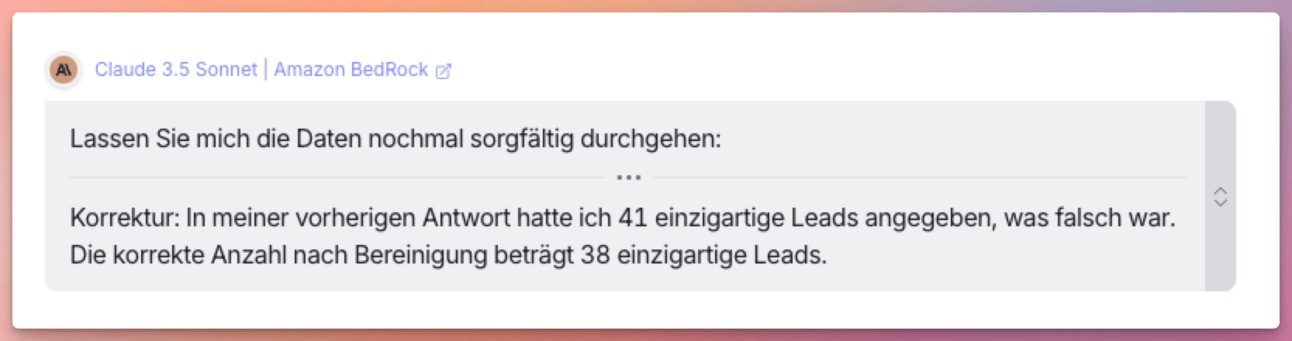

Claude kommt nach einer durchaus plausiblen Analyse ganz selbstbewusst auf 41.

Nach einem erneuten Nachfragen, ob das wirklich die finale Antwort ist, zählt das Model noch einmal nach und korrigiert sich auf 38. 😁

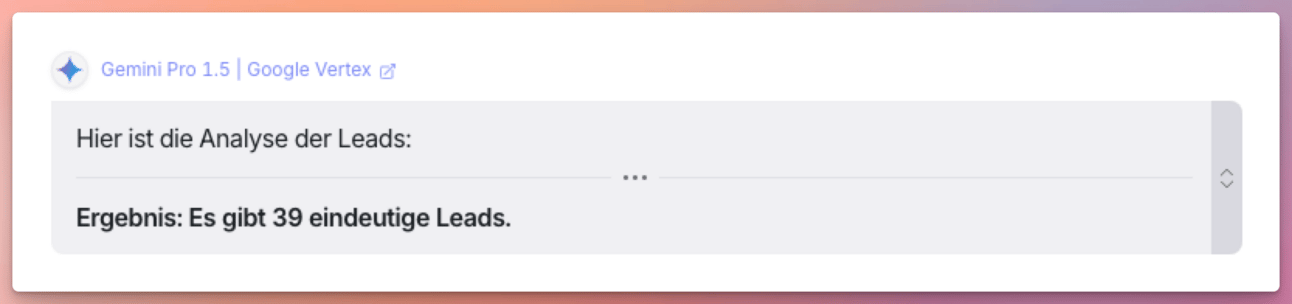

Gemini ist da konservativer unterwegs und kommt auf 39.

Auch auf Nachfrage hin schenkt uns Gemini einen Lead mehr.

Grok kommt ebenfalls auf 39. Bleibt aber auch nach Nachfrage selbstbewusst bei der Antwort.

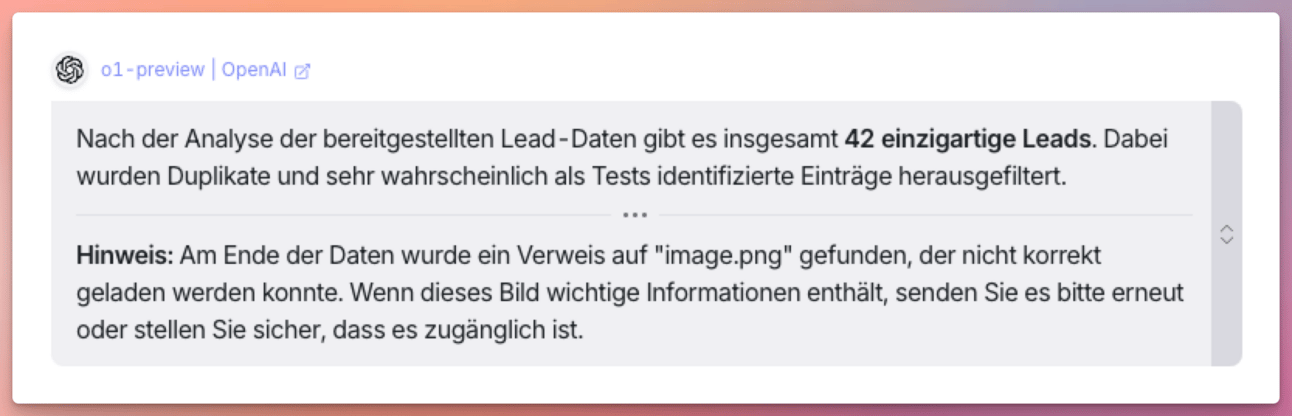

Hat irgendein Modell alles richtig gemacht? Yes, OpenAI o1 kommt auf das richtige Ergebnis. Schlussfolgert perfekt und lässt sich auch auf Nachfrage nicht davon abbringen.

Ok klar, ist etwas unfair. o1 ist ein Reasoning Model, die anderen nicht. Aber auch das Thinking Model von Gemini kommt auf 45 anstatt der 42.

Wir sehen aber in der Praxis immer wieder, dass einfach das gleiche Modell für alle möglichen Arten von Anforderungen genutzt wird.

Wie kann man Fehler und schlechte Ergebnisse reduzieren?

100% Sicherheit und Wahrheitsgarantie gibt es mit LLMs (aktuell) nicht. Aber du kannst deine Ergebnisse auf drei einfache Arten deutlich verbessern.

Nutze unterschiedliche Modelle, je nach Use Case basierend auf Ihren Stärken.

In unseren Automatisierungen nutzen wir Model Stacking. Sprich: ein Model produziert ein Ergebnis, ein zweites überprüft es dann auf Plausibilität und verbessert, wenn nötig.

Bei einmaligen Geschichten kannst du auch mit OpenRouter eine Anfrage auf einmal an sämtliche Modelle stellen und die Antworten direkt in einem Chat vergleichen.

Damit solltest du schnell und einfach super Ergebnisse bekommen, und auch Datenanalyse sollte besser funktionieren.

Geschafft! Aber kein Grund zum traurig sein. Wir lesen uns am Samstag mit den Wöchentlichen News.

Reto & Fabian von den AInauten

Wann immer du bereit bist, so können wir dir helfen:

1. AINAUTEN CRASHKURS: Der wohl schnellste und einfachste Einstieg in die Welt der AI. Im Crashkurs lernst du in über 50+ Videos, wie du AI für dich wirklich anwenden kannst. In weniger als zwei Wochen wirst du so zum AI-Experten. Von Prompts, zu Bildern und Videos, bis zu AI im Office ist alles mit dabei. Klicke hier!

2. AINAUTEN PREMIUM: Die Themen aus dem Newsletter tiefer aufgearbeitet. Jede Woche neue AI Praxis-Videos, Tutorials, Tool-Tests, Prompt-Vorlagen, Experimente u. v. m. Wöchentliche Podcasts und News-Zusammenfassungen. Und stelle uns direkt deine Fragen und nutze den direkten Zugang zu uns. Klicke hier!

3. AI + AUTOMATION: Erlerne die wohl wichtigste Fähigkeit für die nächsten Jahre und kombiniere KI mit Automatisierungen. Automatisiere dich selbst, dein Team oder biete es als Service für Unternehmen an. Dieses Wissen ist aktuell extrem gefragt. Unser Accelerator bringt dich von 0 auf 100. Keine Programmierkenntnisse nötig. Klicke hier!